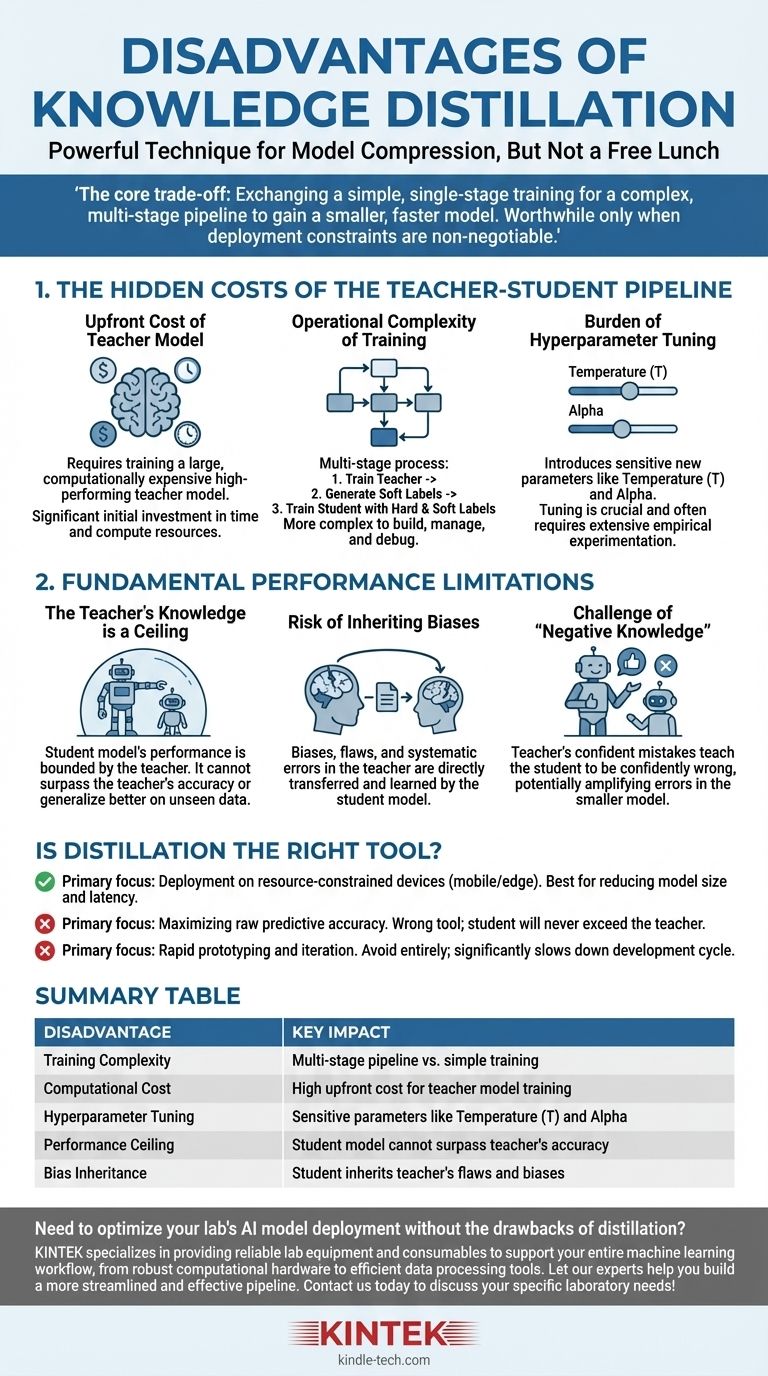

Si bien la destilación de conocimiento es una técnica poderosa para la compresión de modelos, no es un almuerzo gratis. Las principales desventajas son el aumento significativo en la complejidad del entrenamiento y el costo computacional, la introducción de nuevos hiperparámetros sensibles y el límite de rendimiento estricto impuesto por la calidad del modelo profesor.

La compensación central de la destilación es clara: se intercambia un proceso de entrenamiento más simple y de una sola etapa por una tubería compleja de varias etapas para obtener un modelo más pequeño y rápido. Esta inversión en complejidad solo vale la pena cuando las limitaciones de implementación, como la latencia o la memoria, no son negociables.

Los costos ocultos de la tubería Profesor-Estudiante

Los inconvenientes más inmediatos de la destilación no son conceptuales, sino prácticos. Implican el tiempo, los recursos y el esfuerzo de ingeniería adicionales necesarios para gestionar un flujo de trabajo de entrenamiento más complejo.

El costo inicial del modelo profesor

Antes de que pueda comenzar la destilación, necesita un modelo profesor de alto rendimiento. Este modelo es, por diseño, grande y computacionalmente costoso de entrenar.

Esta fase de entrenamiento inicial representa un costo significativo y no trivial tanto en tiempo como en recursos computacionales que debe pagarse antes de que pueda comenzar el entrenamiento "real" del modelo estudiante.

La complejidad operativa del entrenamiento

La destilación es un proceso de varias etapas, a diferencia del entrenamiento de modelos estándar. El flujo de trabajo típico es:

- Entrenar el modelo profesor grande hasta la convergencia.

- Realizar inferencia con el modelo profesor en todo su conjunto de datos de entrenamiento para generar las "etiquetas blandas" o logits.

- Entrenar el modelo estudiante más pequeño usando tanto las "etiquetas duras" originales como las etiquetas blandas del profesor.

Esta tubería es inherentemente más compleja de construir, gestionar y depurar que un script de entrenamiento estándar.

La carga de la sintonización de hiperparámetros

La destilación introduce hiperparámetros únicos que rigen el proceso de transferencia de conocimiento, y requieren una sintonización cuidadosa.

El más crítico es la temperatura (T), un valor utilizado para suavizar la distribución de probabilidad de las salidas del profesor. Una temperatura más alta revela información más matizada sobre el "razonamiento" del profesor, pero encontrar el valor óptimo es un proceso empírico.

Otro hiperparámetro clave es alfa, que equilibra la pérdida de las etiquetas blandas del profesor con la pérdida de las etiquetas duras de la verdad fundamental. Este equilibrio es crucial para el éxito y a menudo requiere una experimentación exhaustiva.

Las limitaciones fundamentales de rendimiento

Más allá de los costos prácticos, la destilación tiene limitaciones inherentes que limitan el potencial del modelo estudiante final.

El conocimiento del profesor es un techo

El rendimiento de un modelo estudiante está fundamentalmente limitado por el conocimiento de su profesor. El estudiante aprende a imitar la distribución de salida del profesor.

Por lo tanto, el estudiante no puede superar al profesor en precisión ni generalizar mejor en datos no vistos. Solo puede aspirar a convertirse en una aproximación altamente eficiente de las capacidades del profesor.

El riesgo de heredar sesgos

Cualquier sesgo, defecto o error sistemático presente en el modelo profesor será directamente transferido y aprendido por el modelo estudiante.

La destilación no "limpia" el conocimiento; simplemente lo transfiere. Si el profesor tiene un sesgo contra un determinado grupo demográfico o una debilidad en un dominio de datos específico, el estudiante heredará exactamente la misma debilidad.

El desafío del "conocimiento negativo"

Si el modelo profesor está confiadamente equivocado acerca de una predicción específica, enseñará al estudiante a estar confiadamente equivocado también.

Esto es potencialmente más dañino que un modelo que simplemente es incierto. El proceso de destilación puede amplificar los errores del profesor, incorporándolos al modelo más pequeño y eficiente donde pueden ser más difíciles de detectar.

¿Es la destilación la herramienta adecuada para su objetivo?

En última instancia, la decisión de usar la destilación depende completamente del objetivo principal de su proyecto.

- Si su enfoque principal es la implementación en entornos con recursos limitados (como dispositivos móviles o de borde): La destilación es una técnica líder para lograr la reducción necesaria en el tamaño y la latencia del modelo, asumiendo que puede permitirse la complejidad de entrenamiento inicial.

- Si su enfoque principal es maximizar la precisión predictiva bruta: La destilación es la herramienta equivocada. Su esfuerzo se invierte mejor en entrenar el mejor modelo independiente posible, ya que el estudiante nunca superará el rendimiento del profesor.

- Si su enfoque principal es la creación rápida de prototipos y la iteración: Evite la destilación por completo. La tubería de varias etapas y la compleja sintonización de hiperparámetros ralentizarán significativamente su ciclo de desarrollo y experimentación.

Comprender estas desventajas le permite implementar la destilación de conocimiento estratégicamente, reconociéndola como una herramienta especializada para la optimización, no como un método universal para la mejora.

Tabla resumen:

| Desventaja | Impacto clave |

|---|---|

| Complejidad del entrenamiento | Tubería de varias etapas vs. entrenamiento simple |

| Costo computacional | Alto costo inicial para el entrenamiento del modelo profesor |

| Sintonización de hiperparámetros | Parámetros sensibles como la temperatura (T) y alfa |

| Límite de rendimiento | El modelo estudiante no puede superar la precisión del profesor |

| Herencia de sesgos | El estudiante hereda los defectos y sesgos del profesor |

¿Necesita optimizar la implementación del modelo de IA de su laboratorio sin los inconvenientes de la destilación? KINTEK se especializa en proporcionar equipos y consumibles de laboratorio confiables para respaldar todo su flujo de trabajo de aprendizaje automático, desde hardware computacional robusto hasta herramientas eficientes de procesamiento de datos. Deje que nuestros expertos le ayuden a construir una tubería más optimizada y efectiva. Contáctenos hoy para discutir sus necesidades específicas de laboratorio.

Guía Visual

Productos relacionados

La gente también pregunta

- ¿A qué temperatura se produce la evaporación? Desbloquea los secretos para controlar la velocidad de evaporación

- ¿Cuál es la regla Delta 20 de la evaporación? Domine la pulverización segura y eficaz

- ¿Es mejor el destilado de THC? Descubre los pros y los contras de la potencia pura frente a los efectos de espectro completo

- ¿Cuáles son los métodos de separación y purificación? Domine las técnicas clave para su laboratorio

- ¿Cuál es la diferencia entre el extracto de THC y el destilado? Una guía sobre el espectro completo vs. la potencia pura